Abbildungen

-

Abbildung 18.1: Die Android Notification Bar wird zum Sammeln und Anzeigen von Notifikationen benutzt, um so die Unterbrechung während der Verwendung von anderen Applikationen des mobilen Gerätes zu reduzieren. -

Abbildung 18.2 : Beispiele für Kartenvisualisierungen, die für Fußgänger entwickelt wurden. Links: ein früher Forschungsprototyp von 2003, Mitte: Nokia Maps, Version 4 von 2009, Rechts: Google Maps von 2014. -

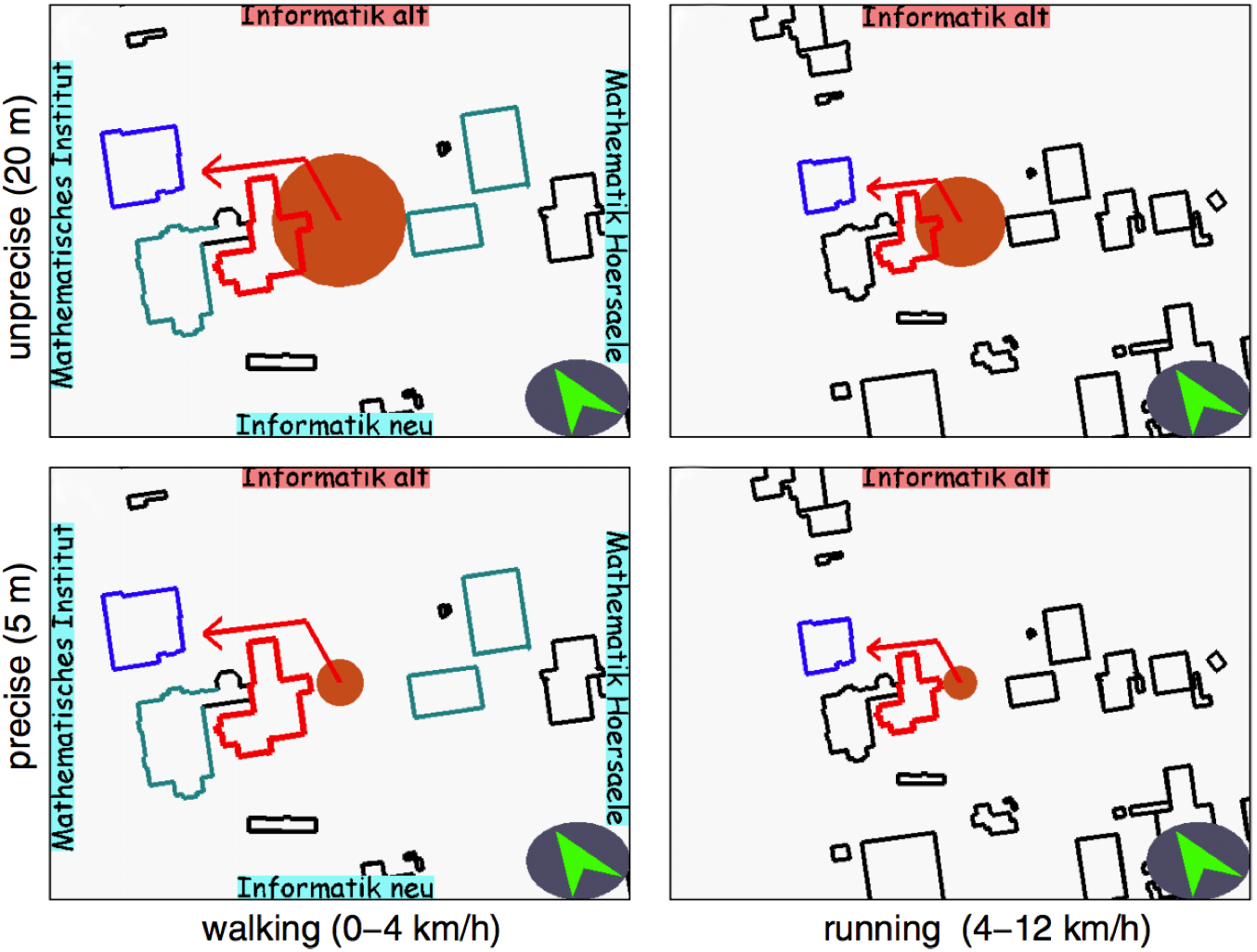

Abbildung 18.3: Beispiel für die grapische Adaptionsleistung des Fußgängernavigationssystems ARREAL aus dem Jahre 2000. Abhängig von der Positionierungsgenauigkeit und der Benutzergeschwindigkeit werden Benutzerposition und Umgebung unterschiedliche dargestellt. -

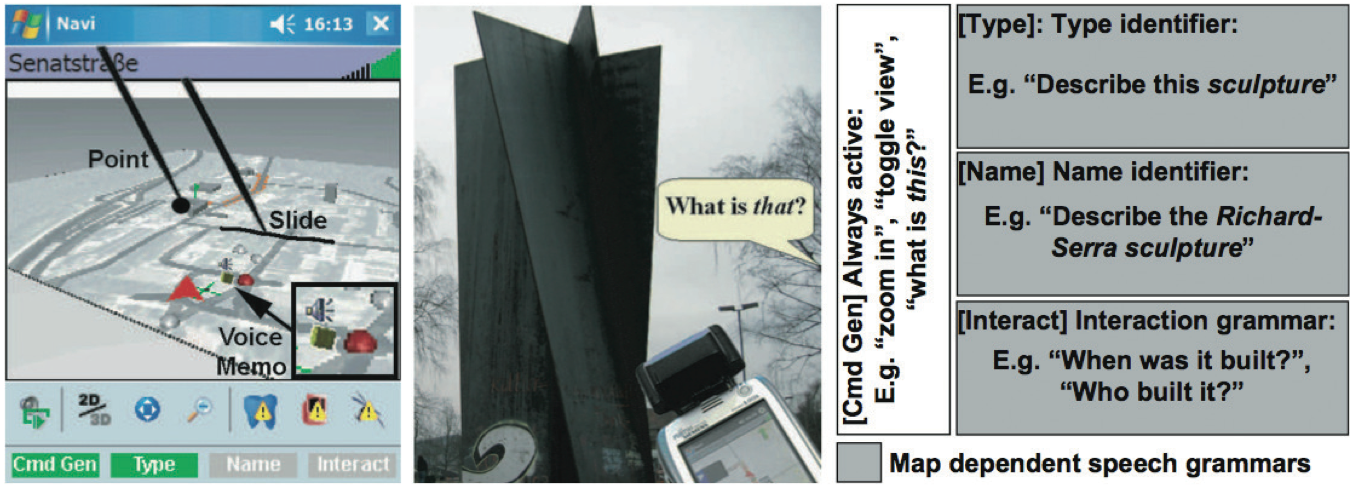

Abbildung 18.4: Multimodale Interaktion mit dem mobilen Fußgängernavigationssystem M3I. In A) wird die kombinierte Verwendung von Gesten auf dem touchsensitiven Bildschirm mit Spracheingaben gezeigt. B) demonstriert die Möglichkeit auch Gesten mit dem Gerät selbst durchzuführen. C) zeigt einen Ausschnitt der Grammatik, die bei der Spracherkennung in Abhängigkeit vom Kartenausschnitt vorausgewählt wird und so die mobile Erkennungsleistung deutlich verbessert . -

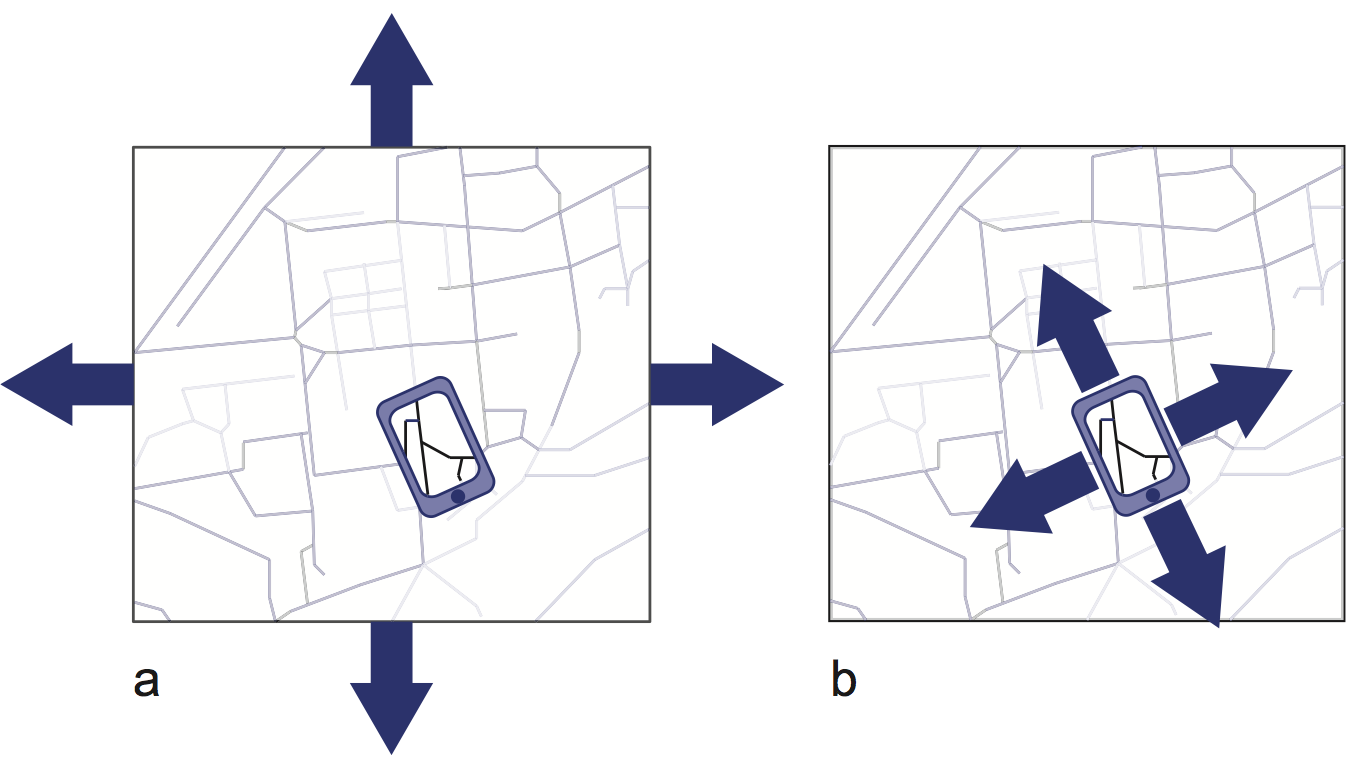

Abbildung 18.5: Visualisierungen, die über eine größere Ausdehnung und Auflösung eines kleinen Bildschirms (Peephole) hinausgehen können auf zwei Arten exploriert werden. A) zeigt die statische Exploration: durch Tasten oder Wischgesten auf dem Bildschirm wird die Visualisierung gegen das statische Peephole verschoben. In B) hingegen wird das Peephole selbst vor der Visualisierung verschoben und ermöglicht so die Exploration der Visualisierung. -

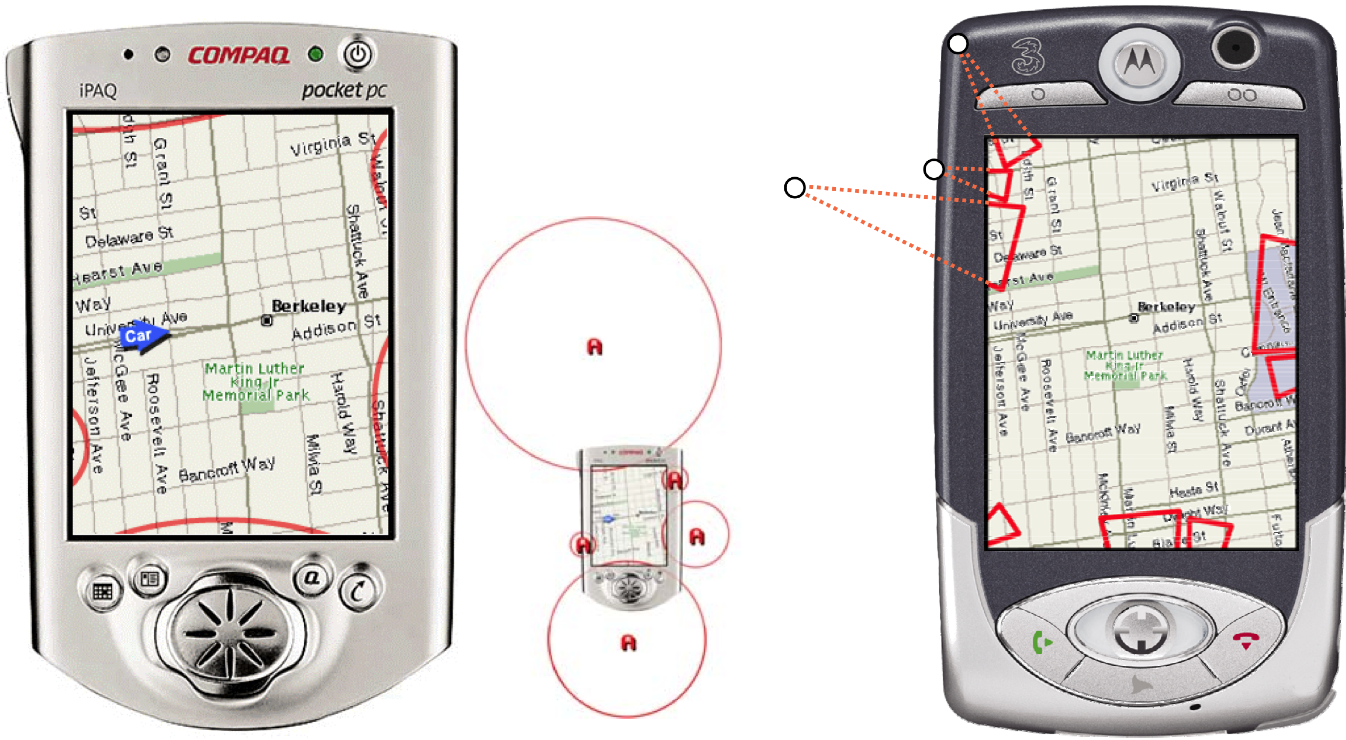

Abbildung 18.6: Links im Bild die Methode Halo zur Visualisierung von off-screen Inhalten. Inhalte außerhalb des Bildschirms werden durch einen Kreisausschnitt auf dem Bildschirm visualisiert. Der Radius und die Lage des Kreises bestimmt sich durch die Entfernung des Inhaltes vom Bildschirmrand. Größere Entfernungen führen daher zu größeren Radien. Rechts im Bild die Methode -

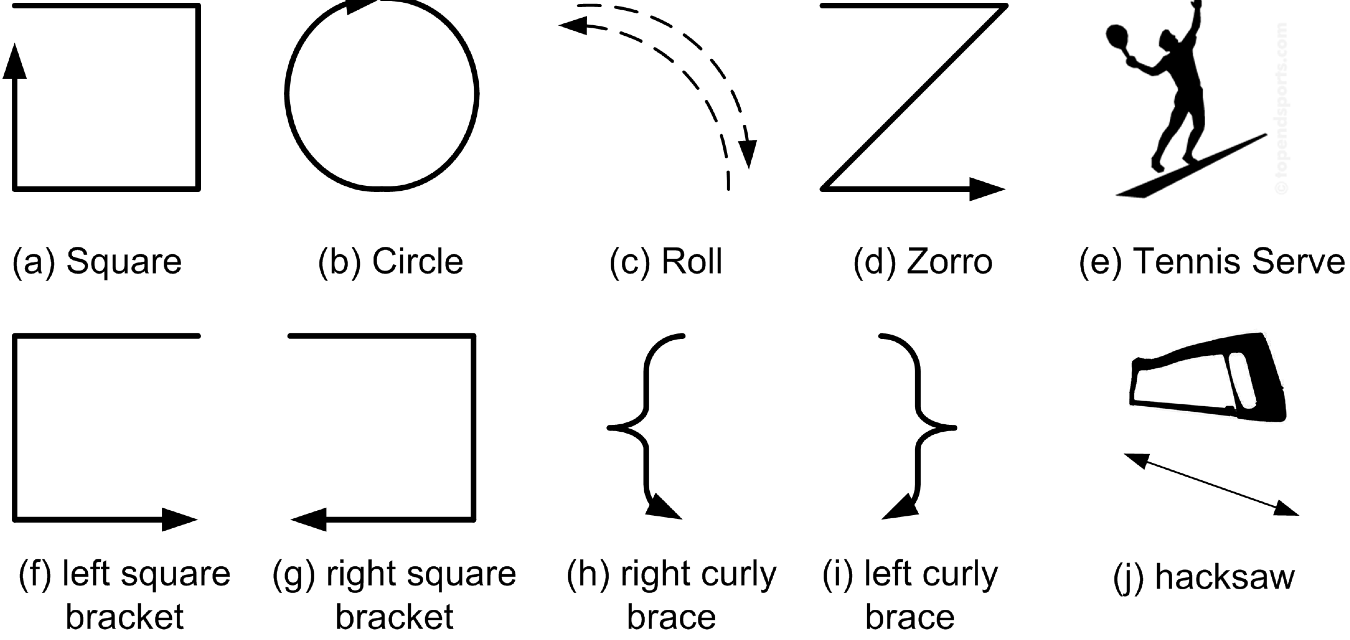

Abbildung 18.7: Eine Menge von einfachen Gesten, die mit einem mobilen Gerät ausgeführt werden können und mit einer Erkennungsrate von 80 Prozent verhältnismäßig robust zu erkennen sind -

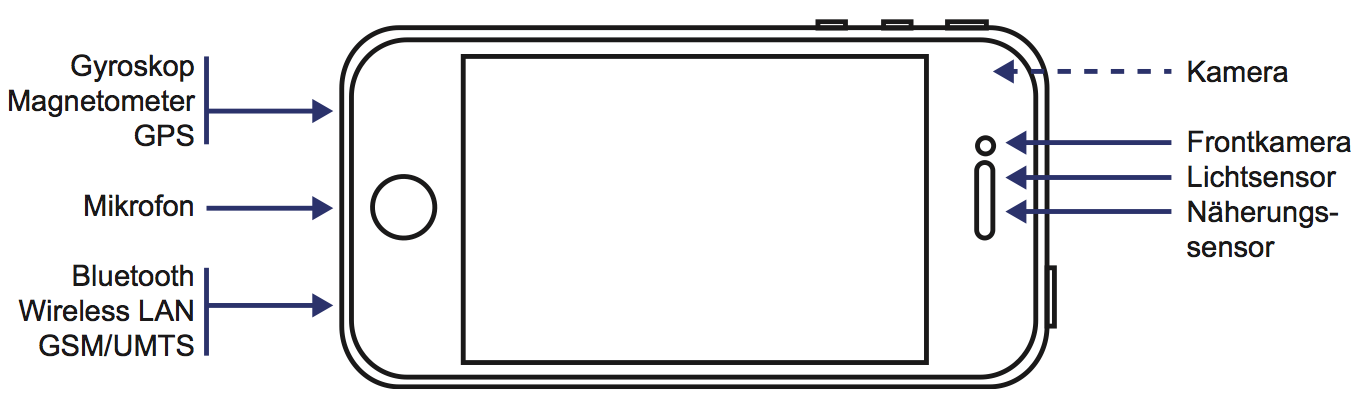

Abbildung 18.8: Beispiel von integrierter Sensorik in einem modernen Smartphone - Hier am Beispiel des iPhone 4 welches mehr als zehn Sensoren besitzt. -

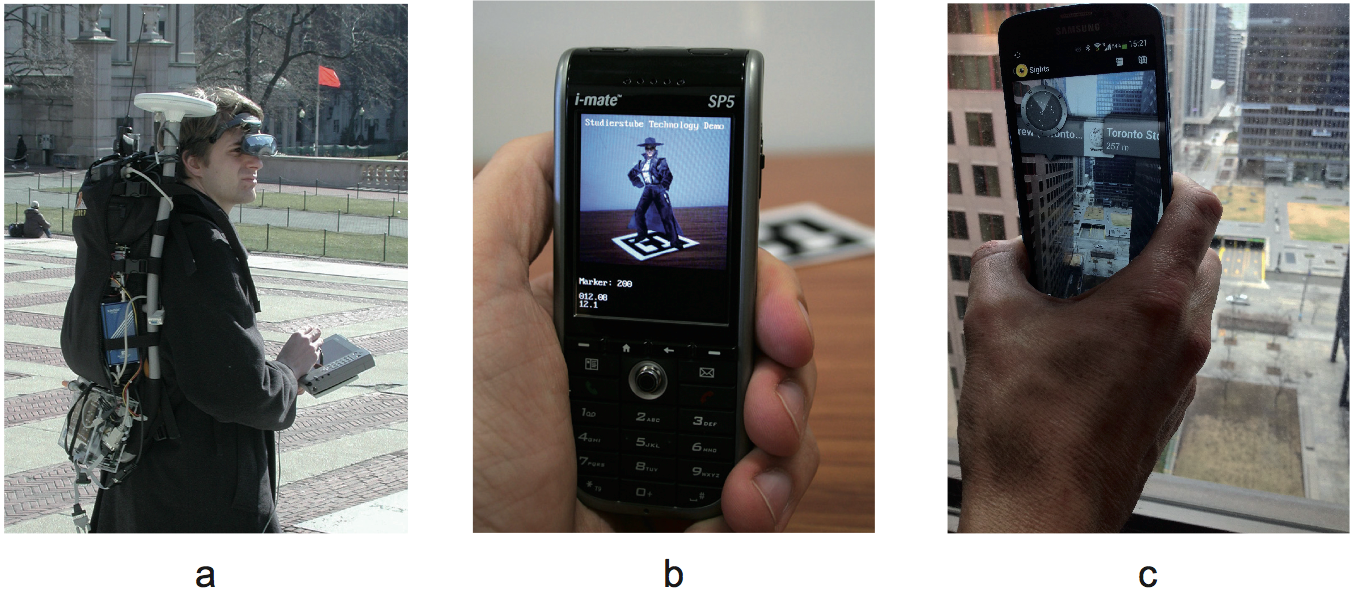

Abbildung 18.9: Mobile Augmented Reality in drei Generationen. Links: eines der ersten tragbaren Systeme Anfang der 2000er Jahre, Mitte: ein markerbasiertes AR-System, welches in der Hand getragen werden kann, Rechts: ein aktuelles Smartphone AR-System.